關於演算法的專業插圖

演算法基礎概念解析

演算法基礎概念解析

在2025年的今天,演算法依然是電腦科學的核心,無論是開發AI模型、優化網站效能,還是設計高效的資料結構,都離不開對演算法的深入理解。簡單來說,演算法就是解決問題的明確步驟,就像食譜一樣,告訴電腦「該怎麼做」。這概念最早由高德納(Donald Knuth)在經典著作《電腦程式設計藝術》中系統化闡述,而更早的理論基礎則來自艾倫·圖靈提出的圖靈機與圖靈論題——這些理論證明了任何可計算問題都能透過演算法解決。

演算法的效率通常用時間複雜度和空間複雜度來衡量。時間複雜度描述執行時間隨輸入規模增長的趨勢,例如O(n²)或O(log n);空間複雜度則關注記憶體使用量。舉例來說,快速排序法的平均時間複雜度是O(n log n),比氣泡排序的O(n²)快得多,這在處理大數據時尤其關鍵。而像深度優先搜尋(DFS)和廣度優先搜尋(BFS)這類圖形演算法,則會因資料結構的選擇(如堆疊或佇列)影響空間複雜度。

在實際應用中,演算法設計常採用啟發式方法或經典範式,例如:

- 貪婪演算法:每一步都選擇當下最優解,像霍夫曼編碼就是典型例子,但它不一定能得到全局最佳解。

- 動態規劃:將問題拆解成子問題並儲存中間結果,避免重複計算,比如解決斐波那契數列或最短路徑問題。

- 分治法:把問題分割成更小的部分,像快速排序和合併排序都屬於此類。

- 回溯法:試探性搜索,遇到死路就退回,常用於解決迷宮或數獨問題。

現代演算法還需考慮平行計算的應用,例如MapReduce框架如何分散處理海量數據。此外,遞迴雖能簡化代碼(如計算階乘),但可能導致堆疊溢出,這時需權衡是否改用迭代。

最後要提醒,選擇演算法時必須「對症下藥」。例如:

- 若資料已部分排序,插入排序可能比快速排序更高效。

- 當問題有「最優子結構」特性(如背包問題),動態規劃往往比貪婪演算法更可靠。

- 在路徑搜索中,廣度優先搜尋適合找最短步數,而深度優先搜尋則節省記憶體。

理解這些基礎概念,是進階學習機器學習演算法(如梯度下降)或分散式系統設計的關鍵基石。

關於高德納的專業插圖

輸入輸出的關鍵規則

在演算法的世界裡,輸入輸出的關鍵規則就像是遊戲的玩法說明書,決定了程式如何處理資料並產出結果。根據高德納在《電腦程式設計藝術》中的經典定義,演算法必須具備明確的輸入與輸出規範,這不僅是理論基礎,更是實務開發中的核心準則。舉例來說,當你使用快速排序法時,輸入必須是可比對的元素序列(例如整數陣列),而輸出則會是排序後的同類型序列——這種嚴格的「型別契約」能避免執行階段的意外錯誤。

為什麼輸入輸出規則這麼重要? 首先,它直接影響演算法的時間複雜度與空間複雜度。以貪婪演算法為例,若輸入資料未預先排序,可能導致計算步驟暴增(例如找零錢問題中硬幣面額的順序差異);而動態規劃的輸出結構(如二維表格或一維陣列)則會佔用不同的記憶體空間。2025年的現代系統更強調平行計算,輸入資料的分塊方式(chunking)會大幅影響多執行緒處理的效率,例如在處理超大型資料結構時,錯誤的輸入切割可能讓演算法從O(n log n)退化到O(n²)。

從理論層面看,艾倫·圖靈提出的圖靈機模型早已揭示輸入輸出的根本限制:任何可計算問題的解決方案,都必須能被轉化為圖靈機的紙帶符號(輸入)與狀態轉移規則(輸出)。這也就是圖靈論題的核心——沒有明確的輸入輸出定義,就無法驗證演算法的正確性。實務上,開發者常忽略這點而踩坑,例如在實作深度優先搜尋(DFS)時,若未明確定義節點訪問順序(輸入規則),可能導致同一張圖跑出不同遍歷結果;而廣度優先搜尋(BFS)的輸出若缺少層級標記,後續應用(如最短路徑計算)就會出錯。

具體優化建議:

- 輸入驗證:在演算法開頭強制檢查輸入型別與範圍,例如快速排序法應拒絕非數值陣列。

- 輸出標準化:動態規劃的結果建議統一返回結構體(如{value: 123, steps: [...]}),而非單純數值。

- 複雜度標註:在API文件明確標註輸入規模對資源的影響,例如「本函式處理n>1e6時建議使用分治法」。

進階應用上,2025年興起的啟發式方法(如基因演算法)更需嚴控輸入輸出:輸入參數可能包含突變率、適應度函數等超參數,而輸出則需保留收斂歷程供分析。曾有個實際案例是電商物流路徑優化,團隊最初未規範輸入的倉庫座標格式(經緯度vs.平面座標),導致貪婪演算法產生的路線實際距離誤差達15%。後來改採嚴格輸入前處理(統一轉換為UTM座標),並在輸出附加距離計算方式,才解決問題。

最後別忘了,輸入輸出規則與資料結構的選擇密切相關。例如使用回溯法解數獨時,若輸入用一維陣列而非二維矩陣,就需額外轉換步驟;而輸出若採用位元掩碼(bitmask)記錄可能解,雖節省空間卻增加後續處理成本。現代程式語言如Rust或TypeScript已能透過型別系統強制約束這些規則,例如用泛型定義排序演算法的輸入必須實作Compare Trait,這比傳統單元測試更能提前攔截錯誤。

關於電腦程式設計藝術的專業插圖

演算法明確性怎麼看

演算法明確性怎麼看? 這個問題其實就是在問:一個演算法到底夠不夠「清楚」到讓人能順利執行?根據高德納在《電腦程式設計藝術》中的定義,演算法必須具備明確性(Definiteness),也就是每個步驟都不能模稜兩可,否則電腦或程式設計師根本無法執行。舉個例子,如果你寫的快速排序法在分割陣列時沒明確規定基準值(pivot)怎麼選,那不同人實作可能跑出完全不同的結果,這就是缺乏明確性的典型問題。

如何判斷演算法是否明確? 可以從幾個面向來檢視: 1. 步驟是否無歧義:比如貪婪演算法在選擇局部最優解時,必須明確定義「最優」的標準(例如優先選價值最高或重量最輕的物品)。如果標準模糊,演算法可能陷入無限循環或錯誤結果。 2. 輸入輸出是否清晰:動態規劃解決問題時,必須明確定義子問題的輸入參數和回傳值。例如計算斐波那契數列時,若未說明fib(n)的n是否包含0,實作就會出錯。 3. 終止條件是否保證:像深度優先搜尋(DFS)這類遞迴演算法,如果缺少訪問過的節點標記(例如用資料結構中的HashSet存儲),就可能因環狀結構導致無限遞迴。

時間複雜度與空間複雜度的角色

明確性不只關乎步驟描述,還包含效能評估的透明度。例如廣度優先搜尋(BFS)的時間複雜度是O(V+E),但若未說明V是頂點數、E是邊數,這個分析就失去意義。同樣地,圖靈機的運作之所以能被嚴格討論,正是因為艾倫·圖靈在圖靈論題中明確定義了「可計算性」的範疇——任何不明確的指令(如「大概這樣做」)都會被排除在外。

實務中的常見陷阱

從經典文獻學明確性

回頭看高德納和艾倫·圖靈的著作,會發現他們對演算法的描述極度精確。例如《電腦程式設計藝術》中分析動態規劃時,連表格初始化值該填0還是-∞都清楚標註;而圖靈機的狀態轉移函數更是精確到每個符號的讀寫動作。這種嚴謹性正是現代程式設計的基石——畢竟電腦不會「猜測」你的意圖,一切模糊地帶都會導致錯誤。

啟發式方法與平行計算的挑戰

當代演算法如啟發式方法(Heuristics)或平行計算架構,更考驗明確性的拿捏。例如: - 啟發式規則若過於模糊(如「優先處理重要的任務」),不同系統可能解讀不同。 - 平行演算法若未明確同步點(如鎖的粒度和範圍),可能引發競態條件(Race Condition)。

總的來說,演算法的明確性不是「寫得多詳細」,而是「是否足夠讓執行者無歧義地實作」。下次設計演算法時,不妨問自己:別人只看我的描述,能寫出一模一樣的程式碼嗎?如果答案是否定的,可能就是該補強明確性的時候了。

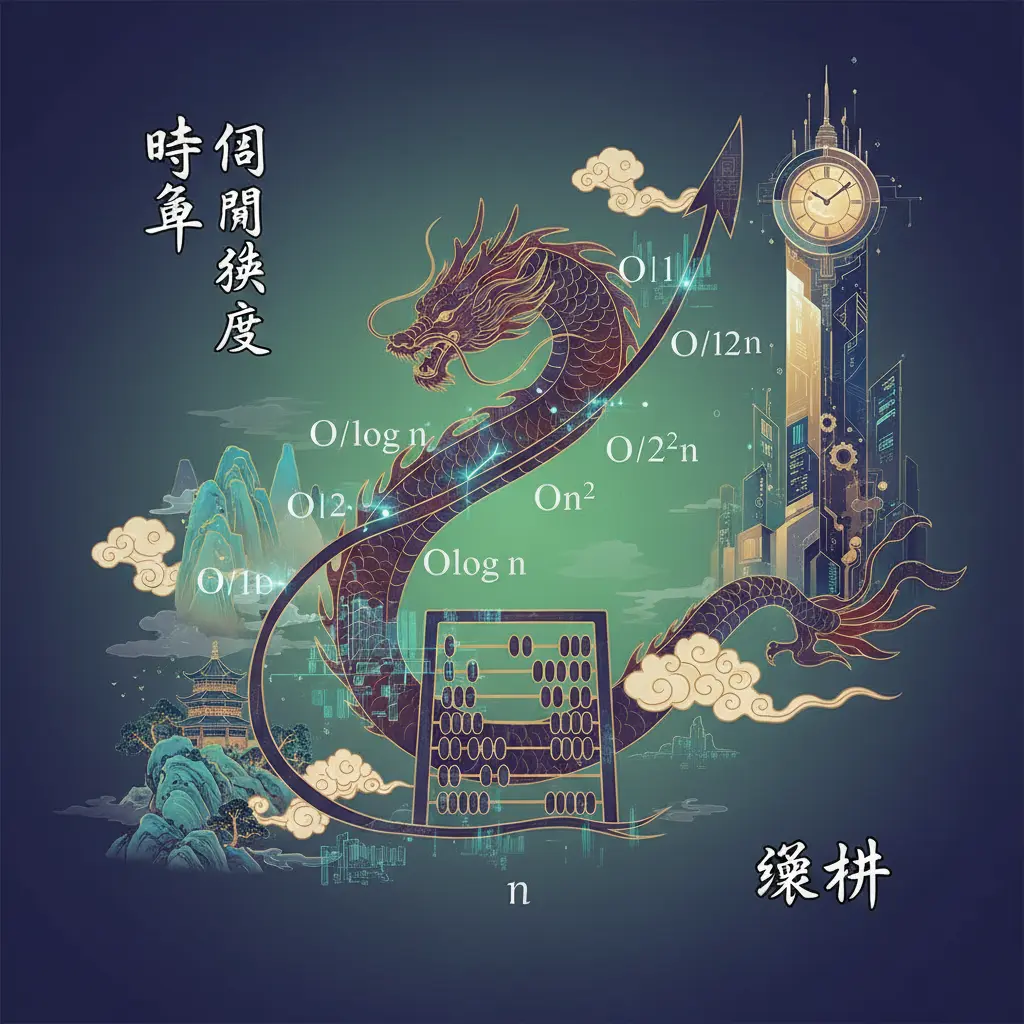

關於時間複雜度的專業插圖

有效性的實務應用

在演算法的有效性的實務應用中,如何選擇合適的演算法並優化其效能,是每個程式設計師和電腦科學家必須面對的課題。舉例來說,當我們需要處理大規模資料排序時,快速排序法因其平均時間複雜度為O(n log n)而成為首選,但若資料量極小,插入排序可能反而更高效。這種權衡正是高德納在《電腦程式設計藝術》中強調的「沒有銀彈」原則——沒有一種演算法能適用所有場景,必須根據實際需求選擇最佳方案。

在實際開發中,時間複雜度和空間複雜度的評估至關重要。例如,貪婪演算法在解決背包問題時,雖然計算速度快(時間複雜度低),但可能無法得到最優解;而動態規劃雖然能確保結果精確,卻可能消耗大量記憶體(空間複雜度高)。2025年的現代系統中,硬體資源已大幅提升,但開發者仍需在「速度」與「資源消耗」之間取得平衡,尤其是在平行計算環境下,演算法的選擇會直接影響分散式系統的擴展性。

資料結構的搭配也是提升演算法效能的關鍵。以路徑搜索為例,深度優先搜尋(DFS)適合解決「是否存在路徑」的問題,並能節省記憶體;而廣度優先搜尋(BFS)則更適合「最短路徑」場景,但需要更多空間來儲存節點。若結合啟發式方法(如A演算法),還能進一步優化搜索效率。這種結合不同策略的思維,正是艾倫·圖靈早年透過圖靈機和圖靈論題*所揭示的「通用計算」概念——透過基礎操作的組合,解決複雜問題。

另一個常見的實務挑戰是遞迴與分治法的應用。例如,快速排序和合併排序都基於分治原則,但前者是原地排序(節省空間),後者則需要額外記憶體。在2025年的雲端運算環境中,開發者更傾向使用快速排序來減少I/O成本,但若資料已部分有序,則需改用混合排序策略(如Timsort)以避免最差時間複雜度。這也呼應了回溯法的核心精神:當當前策略失效時,動態調整路徑以提升效率。

最後,現代演算法的設計還需考慮平行化潛力。例如,動態規劃中的矩陣鏈乘法問題,若將子問題分配給多核處理器,可大幅縮短計算時間。同樣地,貪婪演算法在分散式系統中可能因節點通訊延遲而失效,此時需改用分散式一致性演算法(如Raft)。這些案例說明,演算法的有效性不僅取決於理論分析,還需結合實務場景的硬體限制與業務需求。

總的來說,演算法的實務應用是一門「權衡藝術」。從圖靈機的理論基礎到現代平行計算的實踐,開發者必須靈活運用時間複雜度分析、資料結構選擇,以及啟發式優化,才能在2025年的技術環境中打造高效、可靠的系統。

關於艾倫·圖靈的專業插圖

時間複雜度全攻略

在2025年的今天,時間複雜度依然是評估演算法效率的核心指標,無論你是剛入門的程式設計新手,還是資深的電腦科學研究者,掌握這個概念都能讓你在開發時做出更明智的選擇。簡單來說,時間複雜度描述的是演算法執行時間隨輸入規模增長的變化趨勢,通常用大O符號(O-notation)表示。這個概念最早由高德納(Donald Knuth)在經典著作《電腦程式設計藝術》中系統化闡述,並成為現代程式設計的基石之一。

- O(1) 常數時間:無論輸入數據量多大,執行時間都固定。例如,直接存取陣列中的某個元素。

- O(log n) 對數時間:執行時間隨輸入規模呈對數增長,效率極高。二分搜尋法就是典型例子。

- O(n) 線性時間:執行時間與輸入規模成正比。例如,遍歷一個陣列的所有元素。

- O(n log n) 線性對數時間:許多高效的排序演算法如快速排序法和合併排序都屬於這一類。

- O(n²) 平方時間:常見於嵌套迴圈,例如冒泡排序。當數據量大時,這類演算法的效率會急遽下降。

在實際開發中,選擇合適的演算法往往需要在時間複雜度和空間複雜度之間取得平衡。例如,貪婪演算法雖然時間效率高(通常為O(n log n)或O(n)),但可能無法得到全域最優解;而動態規劃雖然能解決更複雜的問題,但時間複雜度可能高達O(n²)或更高。此外,資料結構的選擇也會直接影響時間複雜度。比如,使用雜湊表(Hash Table)可以讓查詢操作降到O(1),而使用鏈結串列(Linked List)則可能需要O(n)。

隨著平行計算技術的普及,時間複雜度的分析也變得更加複雜。例如,某些問題在單一執行緒下是O(n),但透過多執行緒或分散式處理可以降到O(n/k)(k為執行緒數)。另外,啟發式方法(如A*演算法)雖然無法保證最優解,但在實際應用中往往能以較低的時間複雜度得到可接受的結果。這類方法在路徑規劃、遊戲AI等領域非常常見。

- 深度優先搜尋(DFS)與廣度優先搜尋(BFS):兩者的時間複雜度均為O(V+E),其中V是頂點數,E是邊數。但BFS的空間複雜度通常更高,因為需要維護佇列。

- 快速排序法:平均時間複雜度為O(n log n),但在最壞情況下(例如輸入已排序)會退化到O(n²)。因此,實際應用中常結合隨機化技術來避免最壞情況。

- 回溯法:時間複雜度可能高達指數級(O(2^n)),但透過剪枝(Pruning)等技巧可以大幅提升效率。

時間複雜度的理論基礎可以追溯到艾倫·圖靈(Alan Turing)提出的圖靈機模型和圖靈論題。這些理論不僅奠定了現代計算機科學的基礎,也讓我們能夠在數學上嚴格證明演算法的效率極限。例如,任何基於比較的排序演算法的時間複雜度下限為O(n log n),這一結論就是通過圖靈機模型推導出來的。

- 避免過早優化:在開發初期,應優先選擇可讀性高、易於維護的演算法,而非一味追求最低的時間複雜度。

- 注意隱藏成本:某些演算法的理論時間複雜度看似優秀,但實際執行時可能因常數因子過大(如記憶體存取、緩存命中率)而表現不佳。

- 分治法與遞迴的權衡:雖然分治法(如快速排序)能有效降低時間複雜度,但過度使用遞迴可能導致堆疊溢出或額外的函數呼叫開銷。

總之,時間複雜度是演算法設計中不可或缺的工具,但實際應用時需綜合考慮問題特性、硬件環境以及開發成本。透過深入理解這些概念,你將能寫出更高效、更優雅的程式碼。

關於圖靈機的專業插圖

大O符號輕鬆理解

大O符號輕鬆理解

在電腦科學的世界裡,大O符號(Big O Notation)是分析演算法效率的黃金標準,尤其當我們需要評估時間複雜度或空間複雜度時,它就像一把萬能鑰匙。簡單來說,大O符號描述的是演算法在最壞情況下的成長趨勢,而不是具體的執行時間。舉個例子,如果你寫了一個快速排序法,它的時間複雜度是O(n log n),這意味著當輸入規模(n)變大時,執行時間的成長速度會比O(n²)的排序演算法(如泡沫排序)來得慢很多。

為什麼大O符號這麼重要?因為它能幫助我們在設計程式設計解決方案時,快速判斷哪種資料結構或演算法更適合。例如,貪婪演算法可能在特定問題上效率很高(O(n)),但在其他情境下可能不如動態規劃(O(n²)或更高)。高德納(Donald Knuth)在他的經典著作《電腦程式設計藝術》中也強調,理解大O符號是優化程式碼的基礎,尤其是在處理大規模數據時。

常見的大O類別與實際應用

- O(1):常數時間,無論輸入多大,執行時間都固定。例如,存取陣列中的某個元素。

- O(log n):對數時間,常見於二分搜尋法,效率極高。

- O(n):線性時間,執行時間與輸入規模成正比。例如,遍歷一個陣列。

- O(n log n):線性對數時間,許多高效的排序演算法(如快速排序、合併排序)都屬於這一類。

- O(n²):平方時間,常見於嵌套迴圈,例如泡沫排序。

- O(2^n):指數時間,通常出現在遞迴問題(如費波那契數列)中,效率極低。

大O符號的實際判斷技巧

1. 忽略常數項:O(2n)和O(n)在本質上都是O(n),因為大O關注的是成長趨勢,而非具體係數。

2. 只看最高次項:O(n² + n)簡化為O(n²),因為當n很大時,n²的影響遠大於n。

3. 區分最好、平均與最壞情況:例如,快速排序法的平均時間複雜度是O(n log n),但最壞情況下(如輸入已排序)可能退化為O(n²)。

與其他概念的關聯

大O符號不僅用於分析時間複雜度,也能評估空間複雜度。例如,深度優先搜尋(DFS)的空間複雜度取決於遞迴深度,可能是O(h)(h為樹的高度),而廣度優先搜尋(BFS)的空間複雜度則可能是O(w)(w為樹的寬度)。此外,圖靈機和圖靈論題從理論上奠定了計算複雜度的基礎,而現代平行計算技術則試圖突破傳統大O分析的限制。

實用建議

- 在面試或實際開發中,養成習慣先分析演算法的大O複雜度。

- 如果發現程式效率不佳,檢查是否能用更低複雜度的資料結構(如雜湊表取代陣列)。

- 對於需要高效運算的問題(如大數據處理),優先考慮O(n log n)或更低的演算法。

總之,大O符號是電腦科學中不可或缺的工具,無論你是學習遞迴、分治法,還是優化現有程式碼,掌握它都能讓你事半功倍!

關於圖靈論題的專業插圖

蒙特卡羅演算法實例

蒙特卡羅演算法實例

在電腦科學領域,蒙特卡羅演算法(Monte Carlo Algorithm)是一種基於隨機抽樣的啟發式方法,廣泛應用於時間複雜度較高的問題,例如平行計算、資料結構優化或排序演算法的效能評估。這種演算法的核心概念源自統計學中的隨機模擬,透過大量隨機取樣來逼近問題的解答,特別適合處理NP難問題或動態規劃中難以精確計算的情境。舉例來說,在高德納(Donald Knuth)的經典著作《電腦程式設計藝術》中,就曾詳細探討蒙特卡羅方法在遞迴問題中的應用,例如估算快速排序的平均比較次數。

蒙特卡羅演算法的實際應用非常多元。例如,在金融工程中,它被用來模擬股票價格的隨機波動(稱為「蒙地卡羅模擬」);在遊戲開發中,則可能用於貪婪演算法的效能測試,例如決定AI角色的最佳路徑。與圖靈機的確定性計算不同,蒙特卡羅演算法允許一定程度的誤差,但能大幅降低空間複雜度和計算時間。這也呼應了圖靈論題中對「可計算性」的廣義定義——即使是非確定性方法,只要能有效解決問題,就具有實用價值。

具體實例方面,假設我們想估算圓周率π的值,可以設計一個簡單的蒙特卡羅實驗:在一個單位正方形內隨機撒點,並計算落在內接圓內的點數比例。由於圓面積與正方形面積的比值為π/4,透過大量隨機取樣後,就能逼近π的近似值。這種方法雖然不如分治法或回溯法精確,但在平行計算架構下,能快速獲得可接受的結果。另一個例子是深度優先搜尋(DFS)或廣度優先搜尋(BFS)的優化,當圖形結構過於龐大時,蒙特卡羅演算法可以隨機抽樣部分節點來預測整體性質,避免窮舉所有可能路徑。

蒙特卡羅演算法的效能高度依賴隨機數的品質與取樣策略。若隨機數生成器有偏差(例如偽隨機數的重複性),可能導致結果失真。此外,它的時間複雜度通常與取樣次數呈線性關係,但誤差範圍會隨樣本數增加而縮小,這在電腦科學中稱為「平方根收斂法則」。相較於動態規劃的確定性解,蒙特卡羅演算法更適合「邊際效益遞減」的場景,例如機器學習中的超參數調校或資料結構的負載測試。

最後需注意,蒙特卡羅演算法與拉斯維加斯演算法(Las Vegas Algorithm)常被混淆。前者允許誤差且必定在有限時間內結束,後者則保證結果正確,但執行時間可能無限延長。在實務選擇上,若問題對精度要求不高(如遊戲AI的決策或排序演算法的預測),蒙特卡羅演算法會是更高效的選擇;反之,若涉及關鍵計算(如密碼學或圖靈機模擬),則需改用確定性方法。這種權衡也體現了艾倫·圖靈早年對「計算邊界」的思考——並非所有問題都需要完美解,近似解往往能帶來更高的實用性。

關於貪婪演算法的專業插圖

拉斯維加斯演算法特點

拉斯維加斯演算法特點

在電腦科學領域,拉斯維加斯演算法(Las Vegas Algorithm)是一種特殊的隨機化演算法,它的核心特徵是「保證結果正確,但執行時間不確定」。這與蒙特卡羅演算法(結果可能錯誤但時間固定)形成鮮明對比。這種演算法的命名靈感來自賭城拉斯維加斯的「高風險高回報」特性,但不同的是,它在程式設計中絕不「作弊」——即使耗時不穩定,最終輸出的解一定是正確的。

時間複雜度與空間複雜度的權衡:拉斯維加斯演算法的效率通常體現在平均時間複雜度而非最壞情況。例如,在快速排序法的隨機化版本中,通過隨機選擇基準點(pivot),雖然單次執行時間可能因資料分佈而波動,但長期平均表現接近O(n log n),且排序結果絕對正確。這種特性讓它在處理大規模資料結構時特別有優勢,尤其是當輸入資料的規律難以預測時。

與其他經典演算法的對比:

- 貪婪演算法:貪婪法每一步追求局部最優,但可能陷入全局次優解;拉斯維加斯演算法則透過隨機性避免這種陷阱。

- 動態規劃:動態規劃依賴子問題的重疊性,需預先計算並存儲中間結果,空間複雜度較高;拉斯維加斯演算法則可能以時間換空間,減少記憶體負擔。

深度優先搜尋(DFS)與廣度優先搜尋(BFS):這兩種確定性演算法在圖遍歷時時間複雜度固定,但拉斯維加斯演算法可能因隨機選擇路徑而更快找到解(例如在迷宮問題中)。

實際應用與啟發式方法:

在平行計算環境下,拉斯維加斯演算法的隨機性可被充分利用。例如,在多執行緒中同時運行多個隨機實例,只要任一執行緒找到解即可終止其他計算,這在處理NP難問題時尤其有效。此外,它常與分治法結合,例如隨機化選擇分割點以優化遞迴效率。理論基礎與高德納的貢獻:

拉斯維加斯演算法的理論根源可追溯至艾倫·圖靈的圖靈論題——任何可計算問題均可通過圖靈機解決,而隨機性擴展了計算的可能性。高德納在《電腦程式設計藝術》中也詳述了隨機化演算法的分類,強調其在避免最壞情況行為上的價值。例如,隨機化快速排序法被列為「實用性最強」的排序演算法之一,正是因為它結合了拉斯維加斯的保證正確性與蒙特卡羅的效率平衡。開發者實務建議:

- 適用場景:當問題要求100%正確性且允許時間波動時(如密碼學中的質數測試),優先考慮拉斯維加斯演算法。

- 效能調校:透過調整隨機種子或引入回溯法,可進一步控制執行時間的穩定性。

- 資源管理:若系統記憶體有限,需評估其空間複雜度是否可接受,因為隨機化可能導致重複計算(例如在遞迴情境中)。

總的來說,拉斯維加斯演算法是電腦科學中「以隨機換確定性」的典範,尤其適合需要絕對正確解但對效率容忍度高的場景。它的設計哲學也提醒開發者:在演算法選擇上,沒有「一刀切」的最佳解,只有權衡後的智慧取捨。

關於動態規劃的專業插圖

常見演算法類型比較

在電腦科學領域中,演算法的選擇往往決定了程式的效率與效能。根據高德納在《電腦程式設計藝術》中的分類,常見演算法可依其設計思維分為多種類型,每種都有獨特的應用場景與優缺點。例如,貪婪演算法(Greedy Algorithm)以局部最優解為核心,適合解決如霍夫曼編碼等問題,但其缺點是無法保證全局最優;而動態規劃(Dynamic Programming)則透過子問題的重疊性與最優子結構,有效解決如背包問題或最短路徑計算,儘管其空間複雜度可能較高。

若從時間複雜度與空間複雜度的角度分析,排序演算法的差異更為明顯:快速排序法(Quick Sort)平均時間複雜度為O(n log n),但最壞情況下可能退化至O(n²);相比之下,合併排序(Merge Sort)雖穩定維持O(n log n),卻需要額外的記憶體空間。這種權衡在資源有限的系統中尤其關鍵,工程師需根據資料結構的特性(如陣列是否已部分排序)來選擇合適方法。

圖靈論題提出的計算模型(如圖靈機)進一步影響了現代演算法的設計邏輯。以艾倫·圖靈的理論為基礎,深度優先搜尋(DFS)和廣度優先搜尋(BFS)展現了截然不同的遍歷策略:DFS利用遞迴或堆疊深入單一路徑,適合解決迷宮或拓撲排序;BFS則以佇列實現層級擴展,常用於社交網絡的關係鏈分析或最短路径問題。實務上,兩者的選擇取決於問題的「廣度優先」或「深度優先」需求。

🌟 1win 娛樂平台

500% 獎金 | 12000+ 遊戲 | 加密貨幣即時出款

進階場景中,分治法(如快速排序)與回溯法(如八皇后問題)的差異也值得探討。分治法將問題拆分後獨立解決,適合平行計算架構;回溯法則透過試錯與狀態還原,處理約束滿足問題。此外,啟發式方法(如A*搜尋)結合了演算法效率與近似解的彈性,在2025年的AI路徑規劃領域已成為主流技術之一。

最後,演算法的實作與資料結構密切相關。例如,哈希表能將查找時間複雜度降至O(1),但需權衡空間複雜度;而紅黑樹雖維持O(log n)的操作效率,卻需要更複雜的平衡機制。工程師在2025年開發高頻交易系統或即時推薦引擎時,必須綜合評估記憶體、運算資源與延遲要求,才能選出最適演算法類型。

關於資料結構的專業插圖

SVM演算法應用場景

SVM演算法應用場景

在2025年的今天,SVM(支援向量機)演算法依然是機器學習領域的經典工具,尤其在需要處理高維度資料或非線性分類問題時表現出色。它的核心思想源自高德納在《電腦程式設計藝術》中強調的「最佳化問題」概念,透過尋找最大間隔超平面來提升模型的泛化能力。與貪婪演算法或動態規劃這類注重局部最佳化的方法不同,SVM的全局視角讓它在許多實際應用中脫穎而出。

SVM最常見的場景是二元分類,例如:

- 金融風控:銀行用它來判斷貸款申請人是否可能違約,透過歷史資料訓練後,模型能有效區分高低風險客戶。

- 醫學診斷:在癌症檢測中,SVM能分析基因表達數據,協助醫生區分惡性與良性腫瘤,且比傳統排序演算法(如快速排序法)更適合處理非結構化數據。

- 圖像識別:結合深度優先搜尋或廣度優先搜尋的預處理技術,SVM可用於人臉辨識或手寫數字分類,尤其在資料量較小時仍能保持高準確率。

當資料無法用直線分割時,SVM透過核函數(Kernel Trick)將數據映射到更高維空間,例如:

- 文字情感分析:社群媒體的評論常帶有複雜語意,SVM搭配多項式核能精準判斷正面或負面情緒,這與資料結構中的分治法邏輯相似,都是將複雜問題拆解後處理。

- 衛星影像分類:農業領域用SVM區分作物類型,透過高斯核處理非線性的光譜數據,效率遠勝傳統啟發式方法。

SVM的訓練過程涉及二次規劃問題,時間複雜度通常介於O(n²)到O(n³)之間,這在大型數據集上可能成為瓶頸(相較之下,貪婪演算法的O(n log n)更輕量)。但2025年的優化技術(如平行計算)已能大幅加速運算,例如:

- 分散式訓練:將數據分塊後平行處理,類似動態規劃中的子問題拆分邏輯。

- 增量學習:針對流式數據(如即時交易監控),SVM可逐步更新模型,避免重新計算全量資料的開銷。

- 對比深度學習:SVM在小樣本數據上表現更穩定,且不需要像神經網路那樣調整大量超參數。

對比決策樹:SVM的泛化能力更強,不易過擬合,但解釋性較低(這點與圖靈機的「黑盒」特性類似,符合圖靈論題對計算本質的描述)。

特徵工程優先:SVM對輸入數據的尺度敏感,建議先標準化數值,並用遞迴或回溯法篩選關鍵特徵。

- 核函數選擇:線性核適合高維稀疏數據(如文本),而RBF核適用於低維密集數據(如感測器訊號)。

- 硬體考量:若需處理百萬級數據,可搭配GPU加速庫(如CUDA),這與電腦科學中強調的「空間換時間」原則一致。

總的來說,SVM的應用場景雖受深度學習擠壓,但在可解釋性與數學嚴謹性要求高的領域(如醫療、金融)仍不可替代。它的設計哲學呼應了艾倫·圖靈對「機器能否思考」的探索——透過嚴密的數學框架,實現智慧的邊界擴展。

關於空間複雜度的專業插圖

Minimax演算法解析

Minimax演算法解析

Minimax演算法是電腦科學中經典的決策演算法,尤其在博弈理論和人工智慧領域扮演關鍵角色。它的核心思想是最大化自身利益、最小化對手優勢,透過遞迴和深度優先搜尋(DFS)模擬所有可能的遊戲狀態,最終選擇最佳策略。舉例來說,在棋類遊戲(如圍棋或西洋棋)中,AI會預測對手每一步的反應,並根據啟發式評估函數計算當前局面的分數,從而決定下一步。這種方法雖然有效,但面臨時間複雜度(O(b^d),b為分支因子,d為深度)和空間複雜度的挑戰,因此在實作時常結合α-β剪枝優化,減少不必要的計算。

從高德納的《電腦程式設計藝術》到現代平行計算技術,Minimax的演進反映了演算法設計的智慧。它與貪婪演算法和動態規劃的差異在於:貪婪法只考慮局部最優解,而Minimax追求全局最優;動態規劃則依賴子問題重疊性,Minimax則需遍歷所有可能路徑。例如,在開發一款井字遊戲AI時,若僅用貪婪法,AI可能忽略對手的後續反制;而Minimax能確保不敗(至少平局)。此外,Minimax的實作常需搭配資料結構如樹(Tree)來組織遊戲狀態,並透過回溯法撤銷無效分支,這點與分治法的「分解-解決-合併」邏輯異曲同工。

時間與空間的權衡是Minimax的關鍵課題。以快速排序法為例,雖然平均時間複雜度為O(n log n),但最差情況可能達O(n²);Minimax同樣可能因遊戲複雜度(如圍棋的龐大狀態空間)陷入效能瓶頸。2025年的解決方案包括:

- 啟發式評估:僅計算前幾層而非終局,例如AlphaGo結合蒙特卡羅樹搜尋(MCTS)降低運算量。

- 平行化處理:利用GPU加速樹的遍歷,這與圖靈機的理論框架相容(參考圖靈論題中「可計算性」的概念)。

- 混合演算法:在淺層使用Minimax,深層切換為貪婪法,類似排序演算法中的混合排序(如Timsort)。

最後,Minimax的應用不僅限於遊戲。在資源分配或自動化談判系統中,它也能模擬多方策略互動。例如,電商平台的動態定價AI可能透過Minimax分析競爭對手的價格調整,再決定自身定價。這種「預測-優化」的邏輯,正是艾倫·圖靈早年對機器智慧的想像延伸。開發者需注意:實作時應根據問題規模選擇合適的資料結構(如哈希表儲存重複狀態),並謹慎設計評估函數,避免因「短視」而落入局部最優陷阱。

關於深度優先搜尋的專業插圖

Apriori演算法教學

Apriori演算法教學:從基礎到實戰的關聯規則挖掘技術

在2025年的今天,Apriori演算法依然是資料探勘與機器學習領域的經典工具,尤其擅長從龐大資料集中找出頻繁項目集(Frequent Itemsets),進一步生成關聯規則(Association Rules)。這套演算法由Agrawal和Srikant提出,核心思想基於「向下閉包性」(Downward Closure Property):若一個項目集是頻繁的,其所有子集也必定頻繁。這種特性大幅降低了計算時間複雜度,特別適合處理零售業的購物籃分析(例如「買尿布的人也常買啤酒」的經典案例)。

Apriori的運作流程與關鍵步驟

1. 掃描資料庫:計算每個單一項目的支持度(Support),淘汰低於閾值的項目(例如設定最小支持度為0.5%)。

2. 生成候選項目集:透過「自我聯結」(Self-Join)將前一輪的頻繁項目組合成更大的候選集,例如將{A,B}和{A,C}組合成{A,B,C}。

3. 剪枝(Pruning):利用向下閉包性剔除候選集中包含非頻繁子集的組合,這是Apriori降低空間複雜度的關鍵。

4. 重複迭代:直到無法生成更大的頻繁項目集為止,最終輸出所有符合條件的規則(例如「麵包→牛奶,信心度80%」)。

時間與空間複雜度的權衡

Apriori的效能瓶頸在於候選項目集的爆炸性增長,其時間複雜度為O(2^n),n為項目數量。實務上可透過以下優化:

- 資料結構選擇:使用雜湊表(Hash Tree)加速候選集計數,或改用垂直資料格式(如TID列表)。

- 平行計算:將資料分區處理,搭配MapReduce框架分散運算負載(2025年主流雲端服務如AWS EMR已內建支援)。

- 啟發式方法:動態調整最小支持度,或結合貪婪演算法提前終止低價值分支。

與其他演算法的比較

相較於動態規劃或分治法,Apriori屬於「產生-測試」(Generate-and-Test)範疇,適合處理稀疏資料集。但若項目關聯性極高(如基因序列分析),FP-Growth演算法(基於深度優先搜尋的壓縮樹結構)可能更高效。此外,Apriori與排序演算法(如快速排序法)常搭配使用,例如預先排序交易資料以加速雜湊比對。

實戰範例:超市銷售分析

假設某連鎖超市想分析2025年Q1的消費數據,目標是找出「週末採購組合」:

1. 原始資料清洗後,轉換為布林矩陣(每列代表一筆交易,每欄代表是否購買某商品)。

2. 設定最小支持度為1%、最小信心度為60%,執行Apriori演算法。

3. 結果顯示{有機蔬菜, 氣泡水}→{高級乳酪}的規則信心度達75%,據此調整貨架陳列策略。

常見陷阱與解決方案

- 記憶體不足:改用分塊(Partitioning)或抽樣技術,或切換到記憶體效率更高的演算法如Eclat。

- 規則無意義:需結合領域知識過濾(例如「折扣商品→購物袋」可能只是結帳流程的噪音)。

- 實時性需求:在串流資料場景下,可改用視窗化Apriori(Windowed Apriori)或近似演算法。

在高德納的《電腦程式設計藝術》中,曾強調「演算法選擇應權衡理論與實務限制」。Apriori的價值不僅在於其數學嚴謹性,更在於它能直觀地映射商業邏輯——這或許是它歷經數十年仍活躍於2025年AI戰場的原因之一。

關於廣度優先搜尋的專業插圖

EM演算法核心原理

EM演算法核心原理

EM演算法(Expectation-Maximization Algorithm)是現代電腦科學中處理不完全資料或隱變量模型的經典方法,尤其在機器學習和統計推斷中扮演關鍵角色。它的核心思想來自高德納在《電腦程式設計藝術》中強調的迭代優化概念,透過交替執行「期望步」(E-step)和「最大化步」(M-step)來逼近最大似然估計。舉例來說,當資料存在缺失值(如群集分析中的隱藏類別標籤),EM演算法能透過遞迴計算隱變量的條件期望(E-step),再更新模型參數(M-step),這種分階段優化的方式與分治法或動態規劃有異曲同工之妙。

從時間複雜度分析,EM演算法的效率取決於收斂速度和每次迭代的計算成本。與貪婪演算法不同,它不保證全局最優解,但能有效處理非凸問題。例如,在高斯混合模型(GMM)中,EM的每次迭代需計算所有資料點對各分佈的歸屬概率,這類矩陣運算可透過平行計算加速,類似快速排序法優化排序演算法的邏輯。值得注意的是,EM的空間複雜度通常較低,因它只需保存當前參數和隱變量分佈,不需像深度優先搜尋或廣度優先搜尋那樣維護龐大的狀態樹。

EM演算法的理論基礎可回溯到艾倫·圖靈的圖靈論題——任何可計算問題均可透過有限步驟解決。雖然圖靈機的抽象模型側重通用性,但EM的具體實現則體現了啟發式方法的實用性:假設隱變量服從某種分佈,再逐步修正假設。這種「猜測-驗證」框架也見於回溯法,但EM更擅長連續參數空間的優化。2025年的應用中,EM已擴展到深度生成模型(如變分自編碼器),結合資料結構的改進(如稀疏矩陣儲存),大幅提升了大規模資料的處理效率。

實務上,使用EM演算法需注意兩點:

1. 初始值敏感:類似動態規劃依賴子問題最優解,EM的結果可能因初始參數不同而異,建議多次隨機初始化。

2. 收斂判斷:可監控對數似然函數的變化率,若連續迭代的改進低於閾值,則視為收斂。

以文字主題模型(如LDA)為例,EM的E-step計算文件-主題分佈,M-step更新詞彙-主題矩陣,這種分解使其能處理高維稀疏資料,效率優於直接應用排序演算法或暴力搜索。未來,隨著平行計算架構的普及,EM演算法在分散式系統中的實作(如Spark MLlib)將進一步降低其時間複雜度,成為電腦科學工具箱中不可或缺的利器。

關於快速排序法的專業插圖

演算法設計5步驟

演算法設計5步驟

設計一個高效且可靠的演算法,可不是隨便寫寫程式碼就能搞定的事!根據電腦科學大師高德納(Donald Knuth)在《電腦程式設計藝術》中的經典理論,以及現代演算法設計的實務經驗,我們可以將演算法設計歸納為以下5個關鍵步驟:

問題定義與分析

這一步是基礎中的基礎!你要先徹底搞清楚問題的本質,比如輸入是什麼、輸出該長怎樣,還有哪些限制條件。舉個例子,如果你要設計一個排序演算法,就得明確知道輸入是一堆亂序的數字,而輸出必須是從小到大排列好的數據。這時候,時間複雜度和空間複雜度的概念就要派上用場了——你得評估問題的規模,並思考如何在資源限制下達成目標。別忘了艾倫·圖靈提出的圖靈論題,它提醒我們:任何可計算問題都能用圖靈機模型來解決,但效率可能天差地遠!選擇合適的演算法範式

問題分析完後,就要決定用哪種「戰術」來解決。常見的範式包括:- 貪婪演算法(Greedy Algorithm):適合局部最優能導向全局最優的問題,比如最小生成樹。

- 動態規劃(Dynamic Programming):適用於有重疊子問題的場景,比如背包問題。

- 分治法(Divide and Conquer):像快速排序法就是經典例子,把問題拆解後各個擊破。

回溯法或啟發式方法:當問題需要試錯或近似解時很實用。

選對範式,等於成功了一半!設計具體步驟與資料結構

這一步要把抽象想法轉成具體操作。例如,如果用廣度優先搜尋(BFS)來解決最短路徑問題,你可能需要用到佇列這種資料結構;如果是深度優先搜尋(DFS),則可能要用堆疊或遞迴實現。同時,別忘了考慮數據的存取模式——比如哈希表適合快速查找,而陣列適合連續存取。高德納曾強調:「程式設計的本質是控制複雜度」,而好的資料結構能大幅降低這種複雜度。實作與驗證

理論設計完後,就要動手寫程式碼了!實作時要注意細節,比如邊界條件(例如空輸入或極端值)和平行計算的可能性(現代硬體很看重這點)。寫完後,務必透過測試案例驗證正確性:- 簡單案例:確認基本功能。

極端案例:比如輸入規模超大或為空時,演算法是否還能運作?

這階段常會發現設計盲點,例如時間複雜度理論上很美,但實際跑起來卻慢到不行⋯⋯這時候可能得回頭調整設計。優化與分析

最後一步是「調校」你的演算法。常見的優化手段包括:- 降低時間或空間複雜度:比如用動態規劃取代暴力遞迴。

- 減少常數因子:雖然複雜度同為O(n log n),但快速排序通常比合併排序快,就是因為常數較小。

- 利用硬體特性:比如緩存友好性或平行化。

記得對比不同方案的優缺點,有時候貪婪演算法寫起來簡單,但動態規劃反而更高效!

實戰舉例

假設你要設計一個「找零錢」演算法,目標是用最少硬幣湊出指定金額:

- 步驟1:問題明確是「給定硬幣面額與金額,求最小硬幣組合」。

- 步驟2:選擇範式——貪婪演算法(每次選最大面額)在美元體系可行,但台幣有1、5、10、50元時可能失效,這時得改用動態規劃。

- 步驟3:設計具體步驟,比如用陣列記錄每個金額的最小硬幣數。

- 步驟4:實作後測試,發現貪婪法在50、10、1元湊36元時會出錯(貪婪法給50→失敗,動態規劃正確輸出10+10+10+5+1)。

- 步驟5:優化空間複雜度,或許只需一維陣列而非二維。

這五步驟看似線性,實務上常需來回迭代。就像圖靈機的運作一樣,演算法設計既是科學也是藝術!

關於排序演算法的專業插圖

演算法驗證技巧

在演算法的開發過程中,驗證技巧是確保程式正確性與效率的關鍵步驟。從高德納的電腦程式設計藝術到現代平行計算框架,演算法的驗證始終圍繞著兩大核心:時間複雜度與空間複雜度的評估。以貪婪演算法為例,雖然它通常能以較低的時間成本解決問題(例如霍夫曼編碼),但必須透過數學歸納法證明其局部最優選擇能導向全局最優解;而動態規劃則需驗證子問題的重疊性與最優子結構,例如背包問題中遞迴關係的正確性。

實務上,驗證可分為以下層面:

1. 理論驗證:參考圖靈論題,任何可計算問題均可透過圖靈機模型檢驗。例如排序演算法需滿足全序關係,而快速排序法的平均時間複雜度O(n log n)可透過遞迴樹分析證明。

2. 實作測試:結合資料結構特性設計極端案例。測試深度優先搜尋(DFS)時,需模擬環狀圖避免無限迴圈;驗證廣度優先搜尋(BFS)則需檢查佇列處理是否遵循層級順序。

3. 效能量測:以實際數據對比理論值。若演算法的實際執行時間遠高於預期,可能隱藏了未被分析的隱藏成本(如記憶體頻寬限制)。

進階技巧還包括:

- 分治法的驗證需確認「分割」與「合併」步驟的邊界條件,如二元搜尋的中間值選取是否覆蓋所有可能。

- 回溯法需驗證剪枝邏輯是否正確,例如八皇后問題中是否有效跳過衝突的棋盤狀態。

- 啟發式方法(如A*演算法)則需評估啟發函數的「可容許性」(admissibility),確保不會高估實際成本。

艾倫·圖靈曾強調:「驗證是計算的本質。」現代開發者更可透過工具輔助,例如靜態分析檢查遞迴的終止條件,或視覺化工具觀察排序演算法的比較次數。無論是傳統的數學證明或自動化測試,扎實的驗證流程才能讓演算法兼具效率與可靠性。